EDF SEI migre sa Data dans le cloud et booste la gouvernance

La direction Systèmes énergétiques insulaires d’EDF migre ses cas d’usage Data dans le cloud GCP et prépare le développement de nouveaux usages. Opportunité aussi pour la gouvernance et la qualité.

Plus besoin de présenter EDF, l’énergéticien français. C’est en revanche moins le cas de SEI, sa direction en charge des systèmes énergétiques insulaires, c’est-à-dire les infrastructures d’énergie non raccordées à la métropole (Martinique, Corse, Guyane, Réunion…).

Cette direction d’EDF emploie 3100 collaborateurs dans le monde et couvre 1,2 million de clients. SEI dispose également d’un Data Office de 25 personnes. Et celles-ci sont fortement mobilisées depuis des mois dans le cadre d’une migration de la Data Plateforme sur GCP - un projet échelonné sur plus d’un an.

Un accès aux données robuste, performant et évolutif

EDF SEI assure toute la chaîne de production et de distribution de l’énergie dans le cadre d’un service public (le marché est encore fermé). Mais l’entité s’intègre néanmoins à la stratégie numérique définie par le groupe et embarquant 4 chantiers. Son ambition : accélérer et industrialiser le numérique.

L’amélioration des processus métiers et de l’exploitation des données constituent deux des objectifs du programme numérique d’EDF. La nomination de Stéphanie Delaunay au poste de Chief Data Officer s’inscrit dans ce contexte. Son mandat : créer le Data Office et rénover la stratégie Data de SEI.

“Notre ambition aujourd’hui chez SEI, c’est d’apporter la valeur de la Data et de l’IA au service de la performance métier et de la transition énergétique”, témoignait la CDO à l’occasion de la dernière édition du salon Big Data & AI Paris.

Pour suivre ce cap, trois axes ont été fixés :

La technique “pour permettre un accès aux données robuste, performant et évolutif.”

La gouvernance Data : “nous avons un sujet de qualité de données chez nous (...) L’idée est de disposer de données de qualité, d’une gouvernance maîtrisée, et aussi de permettre une ouverture maîtrisée avec l'extérieur.

L’acculturation : “elle ne peut pas être négligée sur des territoires lointains où Data & IA peuvent être perçus comme des sujets éloignés. L’acculturation est donc importante pour intégrer les traitements au plus près des métiers.”

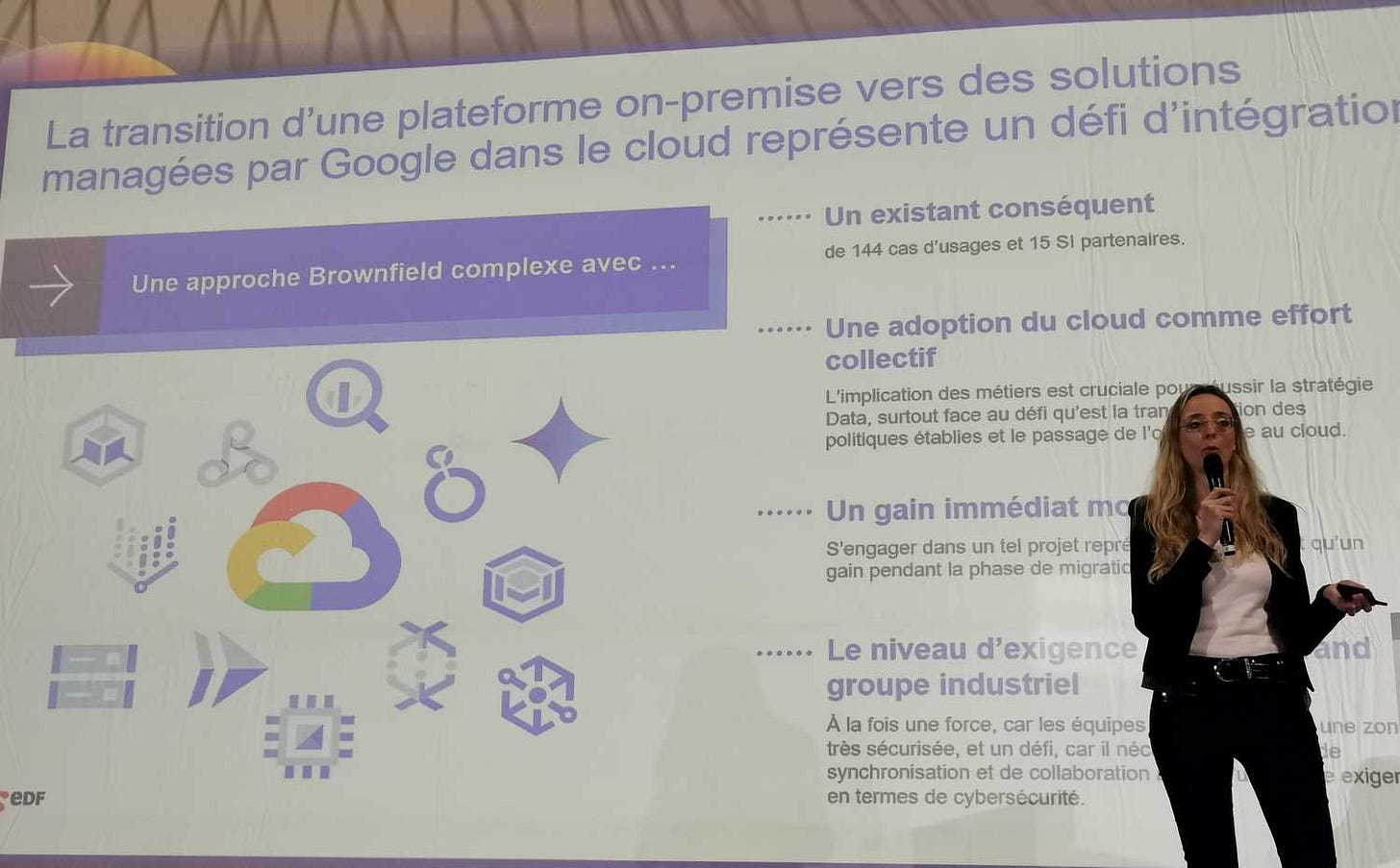

Trois scénarios de migration, dont le cloud public

Sur le volet technologique, EDF SEI devait composer avec une plateforme qualifiée “d’obsolète” par Stéphanie Delaunay. L’existant était constitué de technologies Hadoop “assez anciennes” et donc en fin de support.

De plus, “la plateforme ne supportait plus les évolutions attendues par les métiers”. La décision a alors été prise de procéder à son renouvellement. Le cloud public n’a pas d’emblée été la seule piste d’évolution envisagée.

Plusieurs scénarios ont été examinés, dont le maintien de technologies on-premise, dont Oracle Exadata et une autre distribution Hadoop. Autre trajectoire étudiée : le cloud public afin d’accéder à des services Data managés “et profiter de l’investissement colossal des grands clouders.”

Troisième et dernier scénario sur la table : “rompre avec les préconisations d’EDF” au travers de l’implémentation “d’un solution complémentaire, type Databricks”. Cette piste est écartée car jugée trop complexe à gérer compte tenu de la taille de la structure, mais aussi en raison de la divergence induite avec la politique groupe.

La complexité d’une gestion on-premise a également eu raison du premier scénario. La piste du cloud public s’est imposée et EDF SEI a sélectionné GCP pour héberger sa plateforme Data. Ce choix est justifié par les technologies proposées, “un peu plus avancées sur les sujets Data que ses concurrents”, et par les contrats signés au sein du groupe.

Un PoC pour tester l’intégration avec l’écosystème Data existant

Un PoC a néanmoins été lancé pour confirmer cette décision IT. Le but n’étaient pas d’éprouver les performances des services managés, mais avant tout de tester leur intégration “dans un écosystème Data existant et assez complexe”, mais aussi essentiellement on-premise.

“Notre objectif était de réaliser un PoC en récupérant les données on-prem pour les ingérer sur GCP et les traiter via les services managés Data, puis de réexposer les données sur un outil de datavisualisation on-prem”, détaille la Chief Data Officer.

Les expérimentations visaient par ailleurs à contrôler l’adéquation avec les exigences d’EDF en matière de cybersécurité et de conformité au RGPD. Et comme pour toute migration dans le cloud, un PoC est une étape critique sur les aspects financiers.

“En Data et en IA, les coûts peuvent aller très vite si on les maîtrise mal”, prévient la CDO. Pour mener ce processus, SEI a bénéficié de l’accompagnement du centre d’excellence cloud du groupe. Des compétences essentielles pour envisager la migration des pas moins de 144 cas d’usage existants sur Hadoop.

“Cela exige beaucoup de rework”, indique Stéphanie Delaunay pour souligner la complexité du projet. Il fallait en outre convaincre les métiers en interne. “Ils comprennent l’importance de renouveler la plateforme. Mais ils ont aussi conscience qu’au départ, elle est un centre de coûts et non de gains.”

Du lift & shift pour réduire les délais et l’impact business

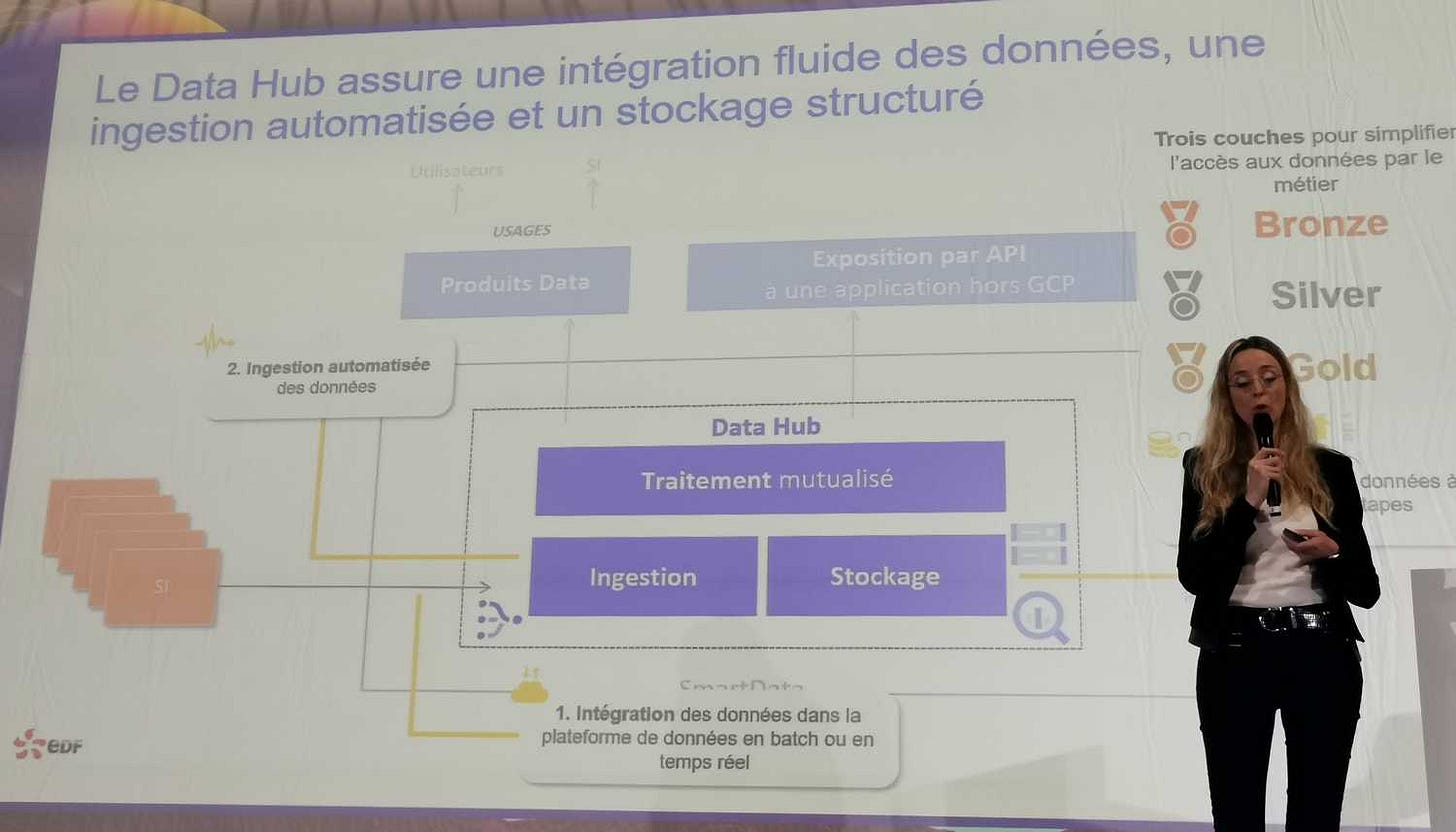

Car les nouvelles applications rendues possibles par l’environnement GCP ne viendront que dans un second temps. “Une migration est un effort collectif”. En effet, d’autres tâches étaient attendues des métiers.

Le chantier devait être mis à contribution pour tirer d’autres améliorations, en commençant par la connaissance des données via leur catalogage. S’y ajoutait un volet de gouvernance Data technique, complémentaire de la gouvernance métier.

Le PoC s’est traduit par une migration effective, réalisée en mode Lift & Shift et avec pour ambition de limiter la période de double run de l’existant et de la plateforme cible. Cette approche se traduit cependant par de la dette technique.

“Nous la résorberons ultérieurement. Les choix technologiques ont des implications, mais ils étaient nécessaires pour réduire le temps de migration et être plus acceptables par les métiers”, explique la CDO d’EDF SEI.

Et la CDO de revendiquer une approche centrée sur le métier et qui s’est ainsi traduite par une priorisation des cas d’usage. Pour des raisons de dépendance, EDF a en outre opté pour des services managés “standards et portables sur un autre clouder, voire même sur des technologies on-prem.”

Gouvernance avec domaines et sous-domaines par métier

Cela n’a pas empêché l’industriel de tirer des gains rapides, en particulier sur l’ingestion des données via l’exploitation de Datastream. Le service a été utilisé “pour accélérer l’intégration des données sans développement de traitements spécifiques.”

Le cloud GCP est aussi mis à contribution pour segmenter les données et améliorer leur stockage dans la plateforme, cite la CDO. La gouvernance des données est effectuée grâce à une interconnexion avec l’outil groupe “afin de rester conforme et de conserver un catalogue unique.”

“Nous avons aussi pu faire un miroir technique de la gouvernance Data définie par le métier en créant des domaines et des sous-domaines de données par métier”, est-il encore précisé. Cette organisation définit le stockage sur la plateforme, mais contribue également à la gestion des accès et à la conformité RGPD.

Pour des raisons de confidentialité et compte tenu du recours à un fournisseur cloud américain, EDF a appliqué le principe de minimisation des données. La minimisation constitue en outre une réponse à des enjeux de coûts et de sécurité.

La migration étant toujours en cours, les gains pour les business sont encore “assez faibles”. Pour contrebalancer cet inconvénient, “et maintenir l’intérêt du métier”, a été constituée une équipe dédiée au développement de nouveaux cas d’usage, “en dehors de GCP pour l’instant.”

Plateforme pour l’IA, le partage de données et le self-service

Ces compétences prendront ensuite en charge les développements sur Google. D’ailleurs, la CDO le souligne, la plateforme cloud en cours de construction constitue “les fondations” des futurs usages. “L’exploitation des services managés Data va se développer” pour intégrer des applications aujourd’hui inexistantes chez SEI comme l’IA et la GenAI.

Grâce à son nouvel environnement cloud, la filiale d’EDF prévoit également de favoriser le self-service. Il s’agit ainsi de donner une autonomie très demandée par les territoires pour la réalisation de traitements liés à leurs particularismes territoriaux.

L’autonomisation devrait d’ailleurs réduire la nécessité de concevoir des outils locaux en complément des solutions nationales. Via GCP, EDF souhaite aussi tirer le partage de données en interne et “sans duplication”. Ces usages visent notamment la création de nouveaux services client, l’amélioration de l'efficacité opérationnelle, à acculturer en interne, etc.

En octobre, la plateforme Cloud hébergeait de premières applications, “beaucoup de BI et de tableaux de bord” axés pilotage de la performance et des opérations. La migration doit durer au total entre 15 et 18 mois.

“Nous avons pris un peu de retard”, reconnaît la CDO. Un délai qui s’explique en grande partie par la complexité liée aux interconnexions pour la récupération des données depuis l’on-prem, ainsi qu’aux interco sortantes. “Exposer des API à des SI sera compliqué,” témoigne-t-elle également.

La Data Quality clé pour l’IA, mais difficile à partager

Une fois le chantier finalisé, EDF SEI entend investir dans le déploiement de l’IA, notamment en complément de données géographiques pour la gestion de ses réseaux. A cette fin, la qualité des données est clé.

La thématique de la Data Quality ne rencontre toutefois pas forcément un grand écho parmi les métiers, dont les priorités business sont ailleurs, par exemple en Guyane où les réseaux sont isolés et les infrastructures difficiles d’accès.

“Ils ne comprennent pas nécessairement l’usage qui sera fait des données qu’ils saisissent”, observe aussi la CDO.

Pour progresser dans ce secteur, ont été nommés des Data Owners, réunis au sein d’une communauté de Data Owners. Ce réseau est animé et les participants “sont accompagnés au quotidien par le Data Office pour cataloguer les données et définir les règles de qualité.”

Sur les territoires sont par ailleurs organisés des Data Days, des rendez-vous d’acculturation portant à ce jour sur les principes et buts de la qualité de données, dont par exemple les finalités d’une bonne saisie de données pour le local et le national.

“C’est ainsi que nous parvenons à améliorer progressivement la qualité de données. Mais cela prendra beaucoup de temps, des années probablement”, concède Stéphanie Delaunay, qui n’est assurément pas la seule CDO à faire ce constat dans son organisation.

Des règles techniques de contrôle de la qualité sont en place. Elles s’enrichissent encore. Se sont à présent les règles métiers qui sont attendues. Grâce à leur implémentation, le Data Office d’EDF SEI table sur des premiers gains en matière de Data Quality d’ici 6 à 12 mois.

Les mots de la Data

Par Morgane Dairain, Chief Data Officer at AVEM (Groupe)

❓Quand l’enfant divine de la maison me dit « Tu sais, parfois je t’entends parler des DataOwners, c’est quoi? Ils font honneur à quoi?»

Passer le rire interne devant les interrogations de mon ingénue, j’ai trouvé cette question très intéressante.

🧐 Et si maîtriser son patrimoine de données c’était un peu honorer son métier?

Les données sont l’or noir d’une entreprise, c’est une ritournelle entendue depuis la fin des années 2000. On a mis des datalab, des CDO, des dataanalystes-scientists-engineers-architectes-lake-warehouse (et de l’IA), bref des écosystèmes entiers mais très IT.

Et moi j’adore en faire partie!

Je mesure la chance de « jouer » avec des données.

Cependant je n’ai jamais été réellement du côté du métier, toujours adjacente.

🔑🤔 Or, qui sont les mieux placés pour parler de leurs données que ceux qui les créent ou les font vivre? Une donnée n’est rien de plus qu’une information générée par une action (humaine ou non) qui fait partie d’un « processus ».

Avec l’arrivée de la Gouvernance des données, des rôles ont émergé et se sont officialisés. Le DataOwner pour ne citer que celui-là est la plupart du temps une personne côté métier. Et naturellement ce rôle est venu (re)mettre la connaissance des données dans les débats de propriété et de responsabilité de maîtrise de la qualité entre les services IT et les métiers.

Alors ce Owner métier, on a voulu l’ embarquer dans la grande famille des Dataquelquechose en lui donnant un nom. Sauf que ça peut effrayer! Car ça le contraint à formaliser des attentes, à ce métier.

Pas de panique car souvent il n’a pas eu besoin de la flopée des DataX pour se demander:

- De quelles informations ai-je besoin pour piloter mon activité?

- Est-ce que je sais définir mes données essentielles ou importantes ?

- Est-ce que les définitions sont claires et partagées avec le reste de l’entreprise

- Qui accède à mes données ?

- Pourquoi ai-je des données de mauvaise qualité alors que mes processus sont à jour? (Du moins je crois?)

🙌🏼 La gouvernance de données est là en soutien à ce DataOwner. Un peu comme un coach. Un coach datalife. Là, pour poser des questions sans toujours donner une réponse satisfaisante, toujours là pour pour rappeler à l’ordre avec bienveillance et garant du maintien de l’objectif ultime : la qualité et la connaissance de son patrimoine de données.

🤓 Alors à mon ingénue je dirais que les DataOwners ont l’honneur d’être mis sur le devant de la scène et de pouvoir orienter les usages de leurs données par une connaissance pleine et maîtrisée qu’ils détiennent. Car un DataOwner connaît (à priori) son patrimoine d’informations mieux que tout ceux qui jouent avec, et sans lui tout Dataquelquechose qu’on soit n’apportera pas de valeur à travailler avec les données.

Vivement la question sur les Datastewards!

PS: écrit et dessin sans IA

Les analyses et actualités Data & IA

Stratégie IA : voici ce que cache le "Plug, baby, plug" macroniste - Le comité interministériel de l’IA officialise les priorités de la 3e phase de la stratégie nationale initiée en 2018. Infrastructures de calcul et puissance énergétique sont au cœur du dispositif.

Auchan pilote son immobilier avec des jumeaux numériques et l’IA - Filière immobilière d’Auchan, Ceetrus a numérisé l’intégralité́ de son patrimoine en France. Grâce aux données et à des agents IA, la foncière peut piloter ses actifs et ses investissements d’un montant de 1 milliard d’euros sur la période 2024 à 2028.

Veolia compte sur Mistral AI pour faire entrer la GenAI sur ses sites industriels - La multinationale française poursuit son déploiement de l’IA générative en s’alliant à Mistral AI pour la gestion de ses sites (eau, énergie et déchets). L’ambition : faire entrer le conversationnel dans ses métiers industriels.

Sur l'IA frugale, le CEA et AMD appellent à la coopération - Le Commissariat à l'énergie atomique et le fondeur vont travailler de concert à l’élaboration de systèmes de calcul efficients pour l’intelligence artificielle. Les applications se destinent aux secteurs de l’énergie et de la médecine.

La CNIL « au début du chemin » sur l’IA - À l’occasion de l’Université des DPO, le secrétaire général de la CNIL est revenu sur le bilan de l’action de la Commission, notamment à destination des délégués à la protection des données personnelles. Louis Dutheillet de Lamothe a aussi précisé le plan de la CNIL sur l’intelligence artificielle.

Pourquoi et comment me contacter ?

Vous êtes CDO, experts de la Data et de l’IA dans une organisation utilisatrice et vous souhaitez partager un retour d’expérience ou mettre en lumière une thématique ? Alors contactez-moi sur LinkedIn.

Vous êtes fournisseur, société de conseil ou éditeur et vous souhaitez proposer du contenu qualitatif à une audience ciblée en figurant dans la newsletter Secrets de Data ? Discutons-en ! [Offre payante]